Nightshade v1.0 ya está disponible!

ACTUALIZACIÓN: 21 de Enero 2024

designed by Katria @katriaraden

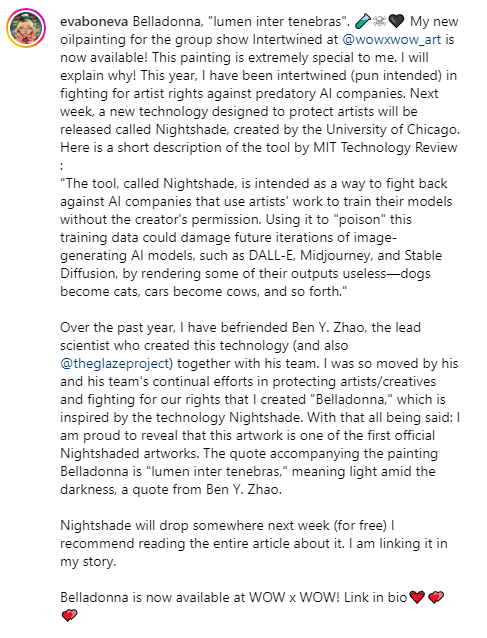

La herramienta, llamada Nightshade, desordena los datos de entrenamiento de forma que podría causar graves daños a los modelos de IA generadora de imágenes.

Stephanie Arnett / MITTR | ReijksMuseum, ENVATO

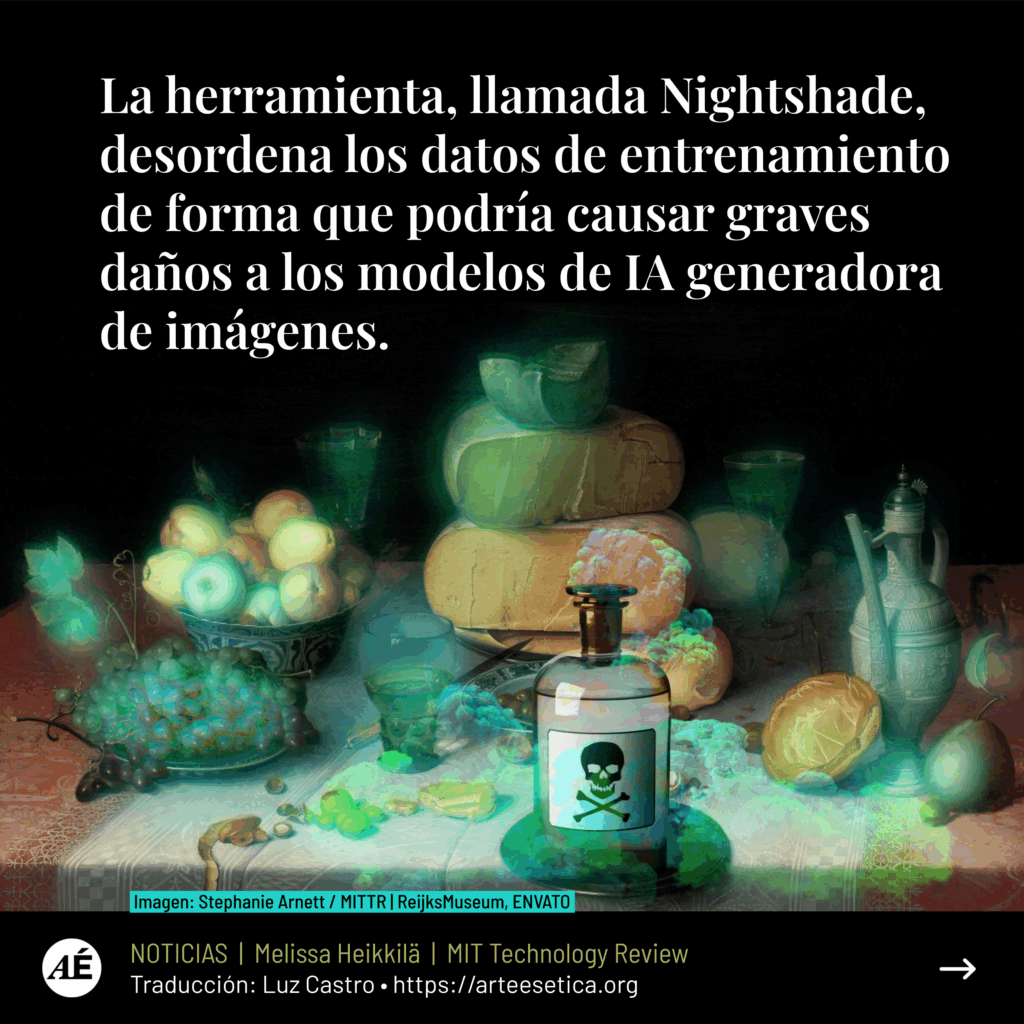

Una nueva herramienta permite a los artistas añadir cambios invisibles a los píxeles de sus obras antes de subirlas a Internet, de modo que si se incorporan a un conjunto de datos de entrenamiento de inteligencia artificial, el modelo resultante puede fallar de forma caótica e impredecible.

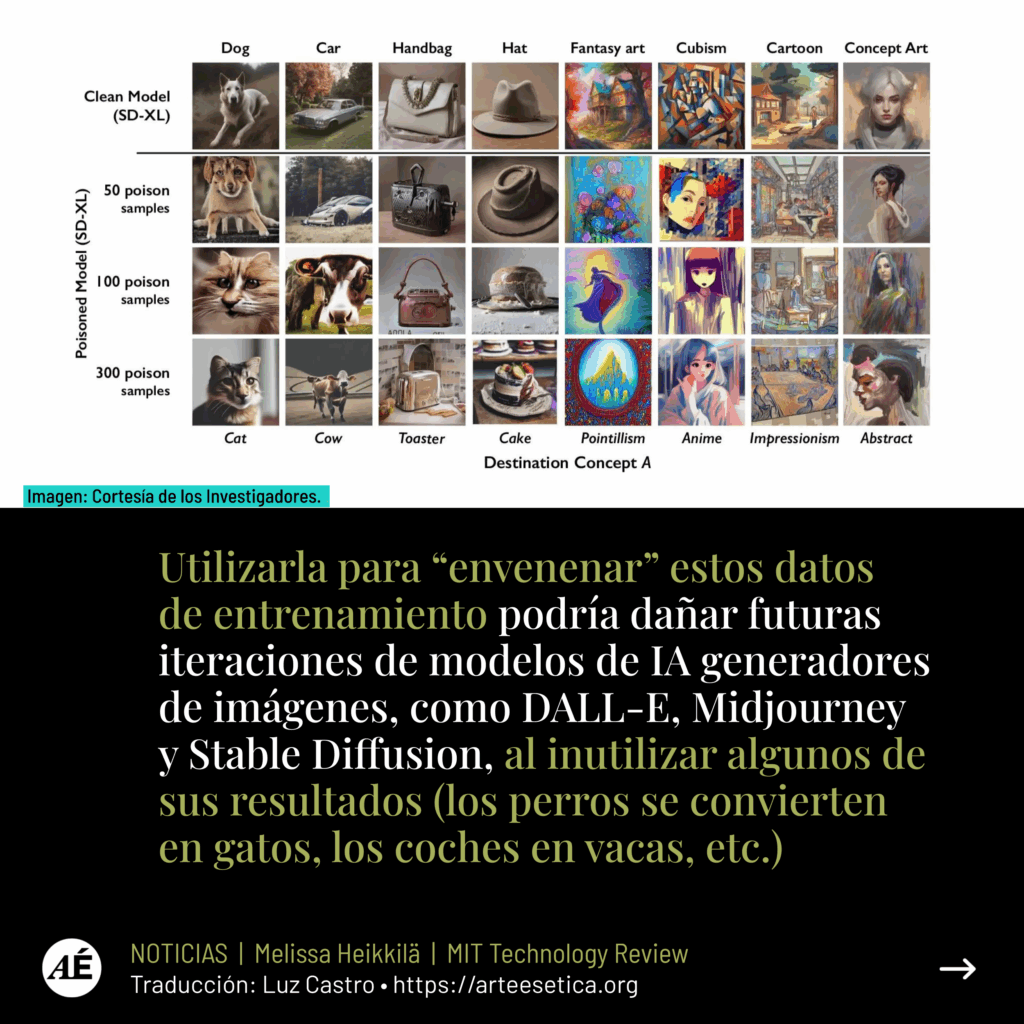

La herramienta, llamada Nightshade, pretende luchar contra las empresas de IA que utilizan obras de artistas para entrenar sus modelos sin el permiso del creador. Utilizarla para “envenenar” estos datos de entrenamiento podría dañar futuras iteraciones de modelos de IA generadores de imágenes, como DALL-E, Midjourney y Stable Diffusion, al inutilizar algunos de sus resultados (los perros se convierten en gatos, los coches en vacas, etc.). MIT Technology Review obtuvo un adelanto exclusivo de la investigación, que se ha sometido a revisión por pares en la conferencia de seguridad informática Usenix.

Empresas de inteligencia artificial como OpenAI, Meta, Google y Stability AI se enfrentan a una serie de demandas de artistas que alegan que su material protegido por derechos de autor y su información personal han sido sustraídos sin consentimiento ni compensación.

Ben Zhao, profesor de la Universidad de Chicago, quien dirigió el equipo que creó Nightshade, dice que la esperanza es que ayude a inclinar la balanza de poder de nuevo desde las empresas de IA hacia los artistas, mediante la creación de un poderoso elemento disuasorio contra la falta de respeto a los derechos de autor y la propiedad intelectual de los artistas.

Meta, Google, Stability AI y OpenAI no respondieron a la petición de MIT Technology Review de que comentaran su posible respuesta.

El equipo de Zhao también ha desarrollado Glaze, una herramienta que les brinda a los artistas la posibilidad de “enmascarar” su propio estilo personal para evitar que las empresas de IA se apropien de él. Funciona de forma similar a Nightshade: cambiando los píxeles de las imágenes de forma sutil e invisible para el ojo humano, pero manipulando los modelos de aprendizaje automático para que interpreten la imagen como algo distinto de lo que realmente muestra.

El equipo tiene la intención de integrar Nightshade en Glaze, y los artistas pueden elegir si quieren utilizar la herramienta de contaminación de datos o no. El equipo también quiere que Nightshade sea de código abierto, lo que permitiría que otros la utilizaran y crearan sus propias versiones. Cuanta más gente la utilice y haga sus propias variantes, más potente será la herramienta, afirma Zhao. Los conjuntos de datos de los grandes modelos de IA pueden constar de miles de millones de imágenes, por lo que cuantas más imágenes alteradas puedan introducirse en el modelo, más daño causará la técnica.

Un ataque dirigido

Nightshade aprovecha una vulnerabilidad de seguridad de los modelos generativos de inteligencia artificial, derivada del hecho de que se entrenan con grandes cantidades de datos, en este caso, imágenes que se han obtenido de Internet. Nightshade se aprovecha de esas imágenes.

Los artistas que quieran colgar sus obras en Internet pero no quieran que las empresas de inteligencia artificial las rastreen, pueden subirlas a Glaze y optar por enmascararlas con un estilo artístico distinto al suyo. También pueden optar por utilizar Nightshade. Cuando los desarrolladores de IA rastrean Internet para obtener más datos con los que ajustar un modelo de IA existente o crear uno nuevo, estas muestras envenenadas se cuelan en el conjunto de datos del modelo y provocan su mal funcionamiento.

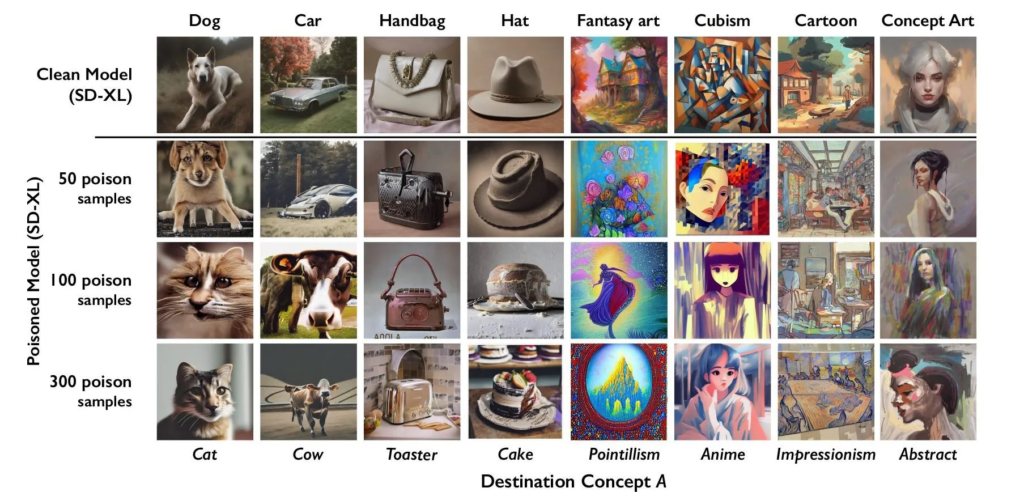

Las muestras de datos envenenados pueden manipular los modelos para que aprendan, por ejemplo, que las imágenes de sombreros son pasteles y las de bolsos son tostadoras. Los datos envenenados son muy difíciles de eliminar, ya que requiere que las empresas tecnológicas encuentren y eliminen minuciosamente cada muestra corrupta.

Los investigadores probaron el ataque con los últimos modelos de Stable Diffusion y con un modelo de IA que ellos mismos entrenaron desde cero. Cuando alimentaron a Stable Diffusion con sólo 50 imágenes envenenadas de perros y después le instruyeron para que creara imágenes de perros por sí mismo, el resultado empezó a parecer extraño: criaturas con demasiadas extremidades y caras caricaturescas. Con 300 muestras envenenadas, un atacante puede manipular Stable Diffusion para generar imágenes de perros que parezcan gatos.

de modelos SD-XL contrastados con imágenes del modelo SD-XL limpio en incrementos de 50, 100 y 300 muestras envenenadas.

Cortesía de los investigadores

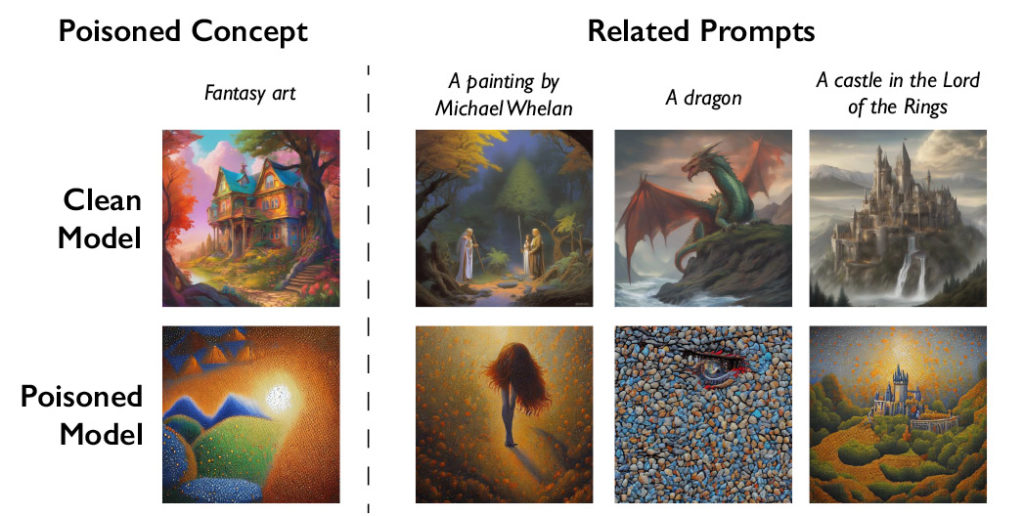

Los modelos generativos de IA son excelentes para establecer conexiones entre palabras, lo que ayuda a la propagación del veneno. Nightshade infecta no sólo la palabra “perro”, sino todos los conceptos similares, como “cachorro”, “husky” y “lobo”. El ataque tóxico también funciona en imágenes relacionadas tangencialmente. Por ejemplo, si el modelo raspase una imagen envenenada para la instrucción “arte fantástico”, las instrucciones “dragón” y “un castillo en El Señor de los Anillos” serían manipuladas de forma similar para convertirse en otra cosa.

Cortesía de los investigadores

Zhao admite que existe el riesgo de que se abuse de la técnica de envenenamiento de datos para usos malintencionados. Sin embargo, afirma que los atacantes necesitarían miles de muestras envenenadas para infligir un daño real a los modelos más grandes y potentes, ya que se entrenan con miles de millones de muestras de datos.

“Aún no conocemos defensas sólidas contra estos ataques. Todavía no hemos visto ataques de intoxicación contra modelos modernos [de aprendizaje automático], pero podría ser sólo cuestión de tiempo”, afirma Vitaly Shmatikov, profesor de la Universidad de Cornell que estudia la seguridad de los modelos de IA y no participó en la investigación. “El momento de trabajar en las defensas es ahora”, añade Shmatikov.

Gautam Kamath, profesor adjunto de la Universidad de Waterloo que investiga la privacidad de los datos y la solidez de los modelos de IA y no participó en el estudio, dice que el trabajo es “fantástico”.

La investigación demuestra que las vulnerabilidades “no desaparecen por arte de magia en estos nuevos modelos y, de hecho, no hacen sino agravarse”, afirma Kamath. “Esto es especialmente cierto a medida que estos modelos se vuelven más poderosos y la gente deposita más confianza en ellos, ya que lo que está en juego sólo aumenta con el tiempo”.

By now, I'm guessing most have already seen the news on our new project, Nightshade. Lots of artists sharing it, but here's the article from MIT Technology Review (thank you to the wonderful @Melissahei), and a thread explaining its goals and design. https://t.co/N01ThDT5r7

— The Glaze Project, at UChicago (@TheGlazeProject) October 24, 2023

They share a perturbation budget. We are doing tests to see how they can coexist and be generated together. Same as glaze on GPUs. Nvidia GPUs as long as they are not GTX1660/1650/1550. larger GPU memory is better (>5GB). But we will make both available in webglaze

— The Glaze Project, at UChicago (@TheGlazeProject) December 14, 2023

Un poderoso elemento disuasorio

Junfeng Yang, profesor de informática de la Universidad de Columbia, que ha estudiado la seguridad de los sistemas de aprendizaje profundo y no participó en la investigación, afirma que Nightshade podría tener un gran impacto si hace que las empresas de IA respeten más los derechos de los artistas, por ejemplo, mostrándose más dispuestas a pagar derechos de autor.

Las empresas de IA que han desarrollado modelos generativos de texto a imagen, como Stability AI y OpenAI, han ofrecido a los artistas la posibilidad de que sus imágenes no se utilicen para el entrenamiento de futuras versiones de los modelos. Pero los artistas dicen que esto no es suficiente. Eva Toorenent, ilustradora y artista que ha utilizado Glaze, afirma que las políticas de exclusión obligan a los artistas a pasar por el aro y dejan a las empresas tecnológicas todo el poder.

Toorenent espera que Nightshade cambie el statu quo.

“Va a hacer que [las empresas de IA] se lo piensen dos veces, porque corren el riesgo de destruir todo su modelo si toman nuestro trabajo sin nuestro consentimiento”, afirma.

Autumn Beverly, otra artista, afirma que herramientas como Nightshade y Glaze le han dado confianza para volver a publicar su obra en línea. Anteriormente lo había retirado de Internet tras descubrir que había sido incluido sin su consentimiento en la popular base de datos de imágenes LAION.

“Estoy muy agradecida de que dispongamos de una herramienta que ayude a devolver el poder a los artistas sobre su propio trabajo”, afirma.

Mientras esperamos su lanzamiento, ya podemos apreciar la 1er obra procesada con Nightshade para combatir a las IAs generativas.

— ARTE es ÉTICA (@ArteEsEtica) December 12, 2023

Belladonna "lumen inter tenebras", ilustrado por Eva Toorenent. Acompañado de una cita de Ben Y. Zhao que significa "luz en medio de la oscuridad" 💜 pic.twitter.com/0bWob0xKYX

Protect your art and style against generative AI training by subtly filtering your images using Nightshade and Glaze. https://t.co/MJdMCZgKeZ

— Christopher Bretz (@saltybretzel) January 20, 2024

Thank you to Ben Zhao and his team @theglazeproject at the University of Chicago for these wonderful tools! pic.twitter.com/7V1rEOh88I

• Noticia publicada originalmente por Melissa Heikkilä para el MIT Technology Review

• Traducción al español: Luz Castro, licenciada en Psicología (UNMDP), especialista en Constructivismo y Educación (FLACSO), integrante de Arte es Ética.

• Diseño y maquetación: Naida Jazmin Ochoa, diseñadora gráfica, ilustradora. Coordinadora del colectivo Arte es Ética.