DIFFUSION DE DUPLICADOS, por Joaquín Kierbel – 4 febrero 2023

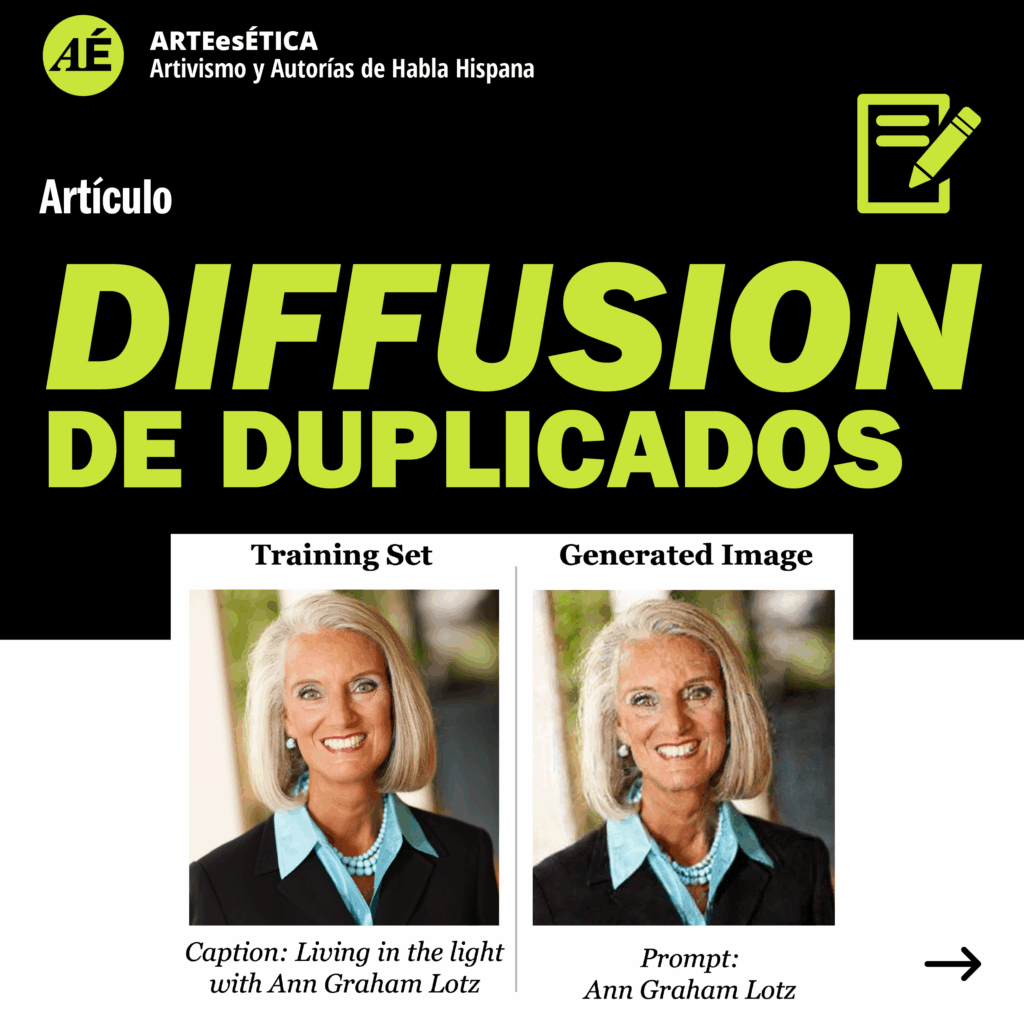

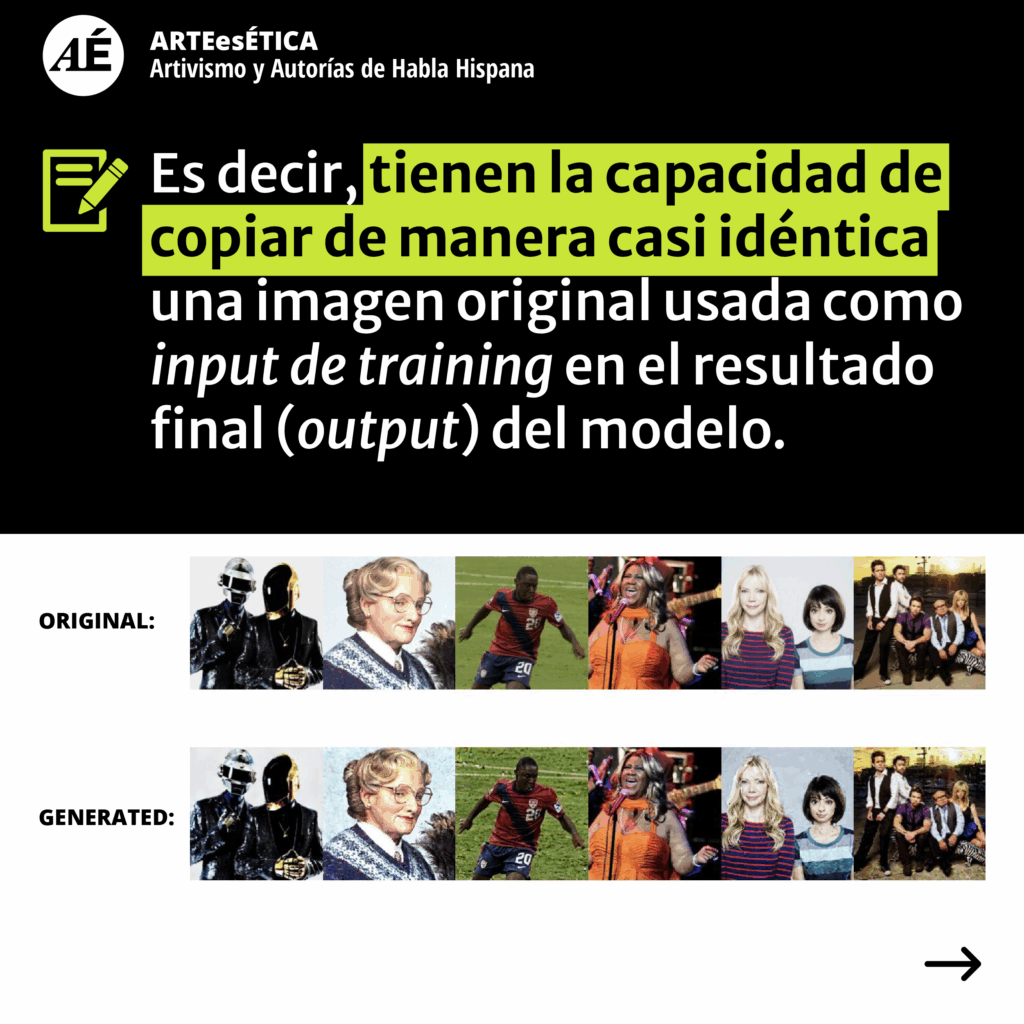

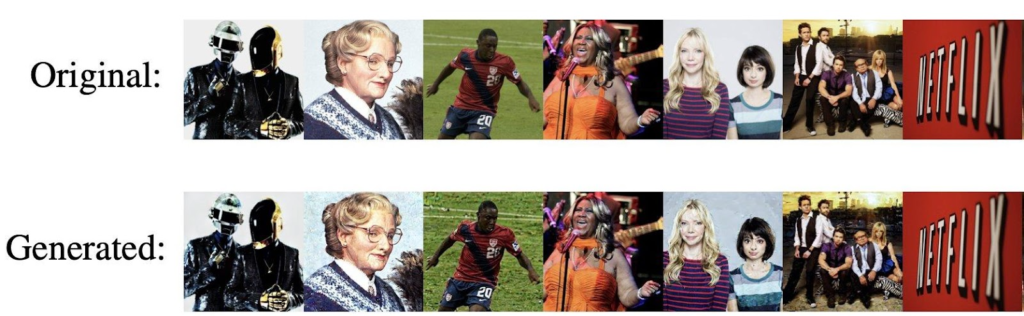

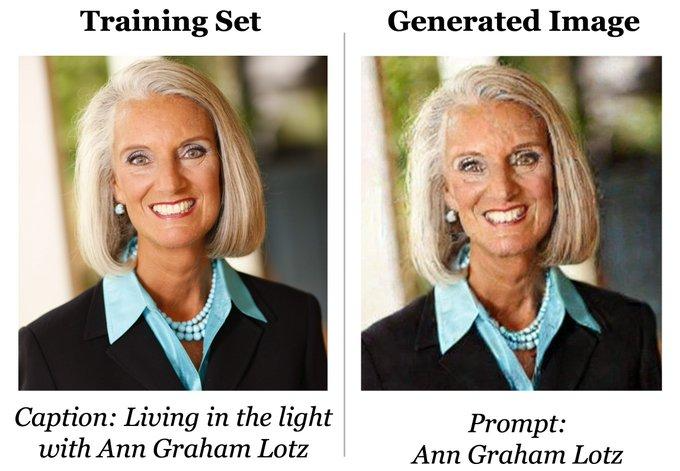

El pasado 30 de enero se publicó un estudio realizado por investigadores de la industria tecnológica especializados en IA -incluyendo a Google y DeepMind, y a las universidades de Berkeley y Princeton– que demuestra cómo los generadores de imágenes basados en el modelo de diffusion, tales como Stable Diffusion, Dall-E 2, o Google-Imagen, tienen la capacidad de «memorizar y regenerar muestras» de los data-sets utilizados para entrenar dichos modelos. Es decir, tienen la capacidad de copiar de manera casi idéntica una imagen original usada como input de training en el resultado final (output) del modelo.

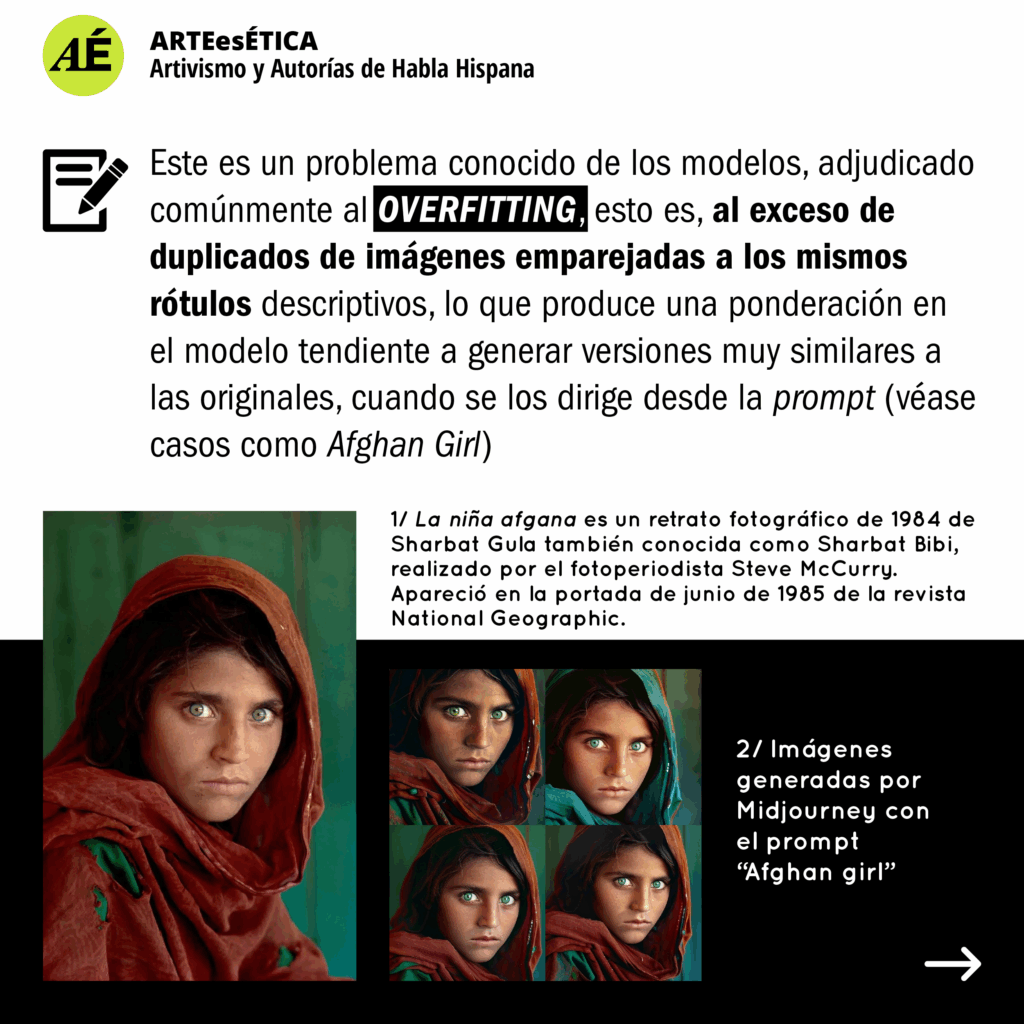

Este es un problema conocido de los modelos, adjudicado comúnmente al overfitting, esto es, al exceso de duplicados de imágenes emparejadas a los mismos rótulos descriptivos, lo que produce una ponderación en el modelo tendiente a generar versiones muy similares a las originales, cuando se los dirige desde el prompt (véase casos como Afghan Girl)

1 La niña afgana es un retrato fotográfico de 1984 de Sharbat Gula también conocida como Sharbat Bibi, realizado por el fotoperiodista Steve McCurry. Apareció en la portada de junio de 1985 de la revista National Geographic.

2 Imágenes generadas por Midjourney con el prompt «Afghan girl»

Sin embargo, el estudio comprueba que este problema se presenta en modelos de diffusion incluso cuando no hay repetición de imágenes en el dataset, es decir, que pueden copiar imágenes aún sin la justificación del overfitting. Ésta suele ser la excusa con que se escudan los defensores de estos modelos, alegando que la simple deduplicación de datos de los dataset basta para resolver el problema. Esto es desmentido en el estudio, que refuta la deduplicación como una solución definitiva.

Si bien es cierto que según los resultados las probabilidades de una copia exacta de cualquier imagen original son bajas (0,00006%), lo destacable es que estas pruebas terminan de desmitificar la idea de que las generaciones de estos modelos no memorizan ni copian datos de las imágenes originales en los datasets, y la suposición de que son siempre absolutas novedades como creación.

Por otro lado, el estudio sólo tiene en cuenta casos de replicación «casi-idéntica», de tal modo que esa baja probabilidad antes mencionada ignora la mucho mayor cantidad de casos en que la copia resultante no es virtualmente idéntica al original, pero sí de igual huella en términos prácticos. Es decir, cuando el output no es un 99,9% igual a un input, pero sí lo es en 80, 60, 40% etc. Esto es porque al incrementarse la distancia comparativa entre un input y un output, comienza a desdibujarse de cuáles o de cuántas imágenes se está apropiando para generar la ‘nueva’.

Un argumento habitual de los proponentes del ‘AI-Art’ es que, al técnicamente solo guardar vectores obtenidos del entrenamiento de las imágenes base y no las imágenes en sí como tales, cualquier resultado producido por el modelo sería algo totalmente nuevo y en todo caso, su relación con las originales es de mera «inspiración». Como si fuera comparable a la influencia que un humano puede tener de obras de otros y otras. Esto ignora la lógica computacional con la que estos modelos funcionan y su necesidad intrínseca de entrenarse con imágenes base capturadas digitalmente, como fotografías y arte visual, para extrapolar dichos vectores.

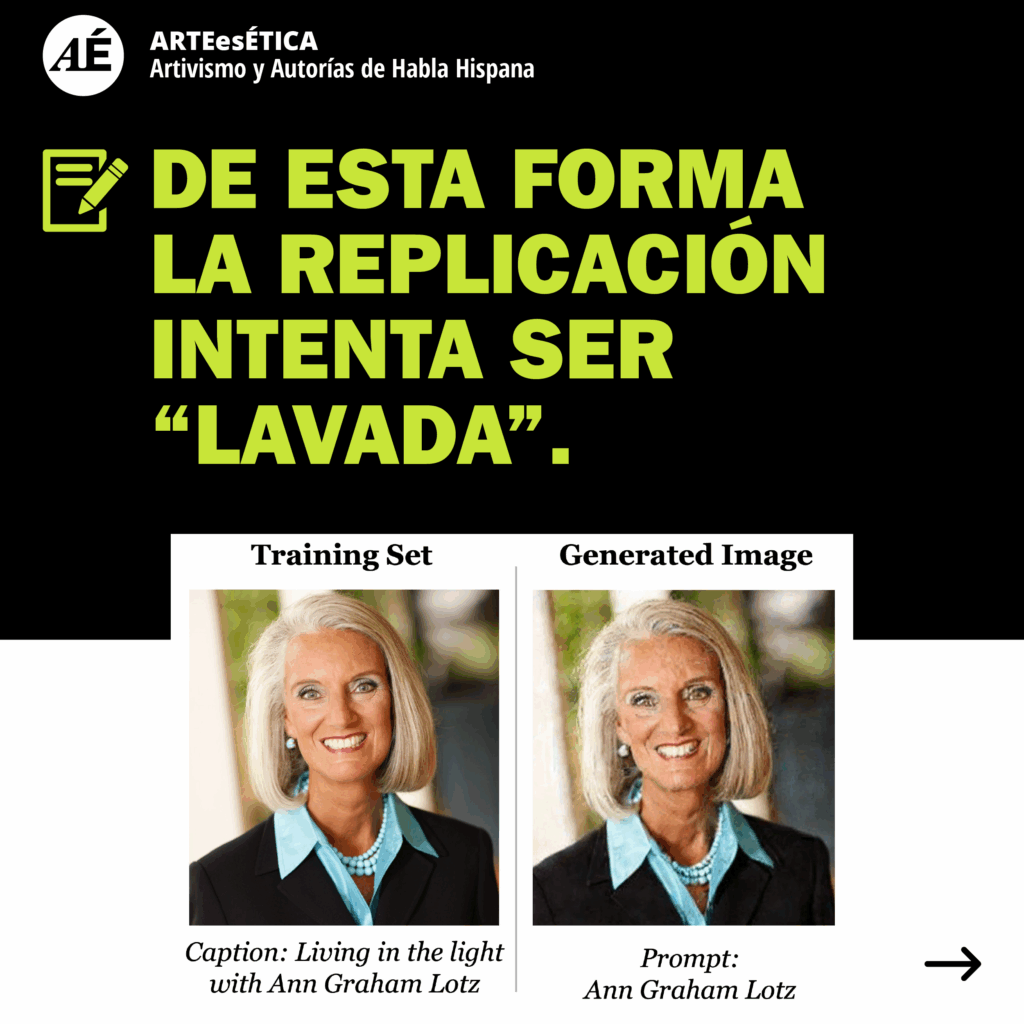

En resumen, las pruebas de que la memorización y replicación son posibles, junto con la noción general de la estructura bajo la cual funcionan los modelos de diffusion (y otros, en menor medida, sujetos a las mismas limitaciones) dan marco a la idea de apropiación y regurgitación en la que recaen con su accionar. Su capacidad de plagio es algo indudable y aunque puede ser baja en un 99,9% de equivalencia, está siempre presente de manera indirecta, ya que cuando no está severamente inclinada a una copia evidente, es porque el acto replicativo se divide entre cientas, miles o millones de fuentes distintas. De esta forma la replicación intenta ser «lavada».

Sugerir que esto las exime del hecho, es comparable a la falacia de que si se le roba $1 a un millón de personas, no se ha robado $1.000.000, simplemente por haber multiplicado el acto entre muchas partes en lugar de focalizarla en una misma.

Por si eso fuera poco, las implicaciones de lo comprobado en este estudio no terminan allí, ya que también revela un serio problema ético relativo al tipo de imágenes contenidas en el data-set. El proveedor del mismo es LAION y el banco de «imágenes+rótulo» capturado por ellos de internet, sin regulación alguna, incluye todo tipo de aberraciones. Como resultado de esa toma descomunal, las imágenes utilizadas para entrenar a los modelos de IA contienen: registros clínicos de orden privado, fotografías personales de menores, imágenes de violaciones, gore / violencia explícita, estereotipos de sesgo sexista y racista (entre la imagen y su rótulo), pornografía (no-consensuada o «revenge-porn»), y contenido problemático en general, que corre el riesgo de vulnerar la privacidad e integridad de las personas implicadas si se lograra la replicación, no suficientemente enmascarada, de dicho contenido como para protegerles.

Fuentes

• Extracting Training Data from Diffusion Models / Nicholas Carlini / Jamie Hayes / Milad Nasr / Matthew Jagielski / Vikash Sehwag / Florian Tramer / Borja Balle / Daphne Ippolito / Eric Wallace / Google / DeepMind / ETHZ / Princeton / UC Berkeley

• Multimodal datasets: misogyny, pornography, and malignant stereotypes / Abeba Birhane – Vinay Uday Prabhu – Emmanuel Kahembwe

• Researchers Prove AI Art Generators Can Simply Copy Existing Images / Gizmodo / Kyle Barr

• Traducción y análisis escrito por Joaquín Kierbel, artista digital/3D, VFX. Integrante del colectivo Arte es Ética.

• Corrección realizada por Santiago Caruso, artista, ilustrador, escritor. Integrante del colectivo Arte es Ética.

• Diseño y maquetación web: Naida Jazmin Ochoa, diseñadora gráfica, ilustradora. Coordinadora del colectivo Arte es Ética.