Aunque los líderes de la industria defienden el desarrollo de la IA para luchar contra el cambio climático en el futuro, la IA aumenta consumos y emisiones hoy. La pregunta es cuánto y si ya nos hemos pasado los límites de la eficiencia energética

Marilín Gonzalo | Algoritma | NEWTRAL

OpenAI, cuya misión declarada es crear una inteligencia artificial general o AGI para trabajar en beneficio de la humanidad, incluye el cambio climático como uno de los principales desafíos globales que la IA viene a solucionar. Una de las promesas del avance digital había sido que nos haría gastar menos recursos naturales. Pero ha demostrado ser un mito: el traslado de gran parte de nuestra actividad a las redes desde hace años implica más impacto energético: más consumo de minerales para hardware, más energía para hacer funcionar las redes y equipos, más agua para refrigerar los centros de datos y más emisiones de carbono en todo el proceso. La promesa se ha renovado ahora con ChatGPT y el bombo de la industria de la IA generativa.

Su líder, Sam Altman, pide mirar al futuro. En una conversación con The Economic Times en junio, dijo a su entrevistador: “Es un error enfocarnos demasiado en los sistemas de AI actuales, en sus límites, capacidades o impacto”, y que “lo que importa es que estamos en una curva exponencial: un sistema futuro puede curar todas las enfermedades o ayudarnos a afrontar el cambio climático”.

Altman no está solo en esta última esperanza: el 87% de los líderes que supervisan temas relacionados con el clima y la IA creen que ‘la IA’ es un activo valioso en la lucha contra el cambio climático, según un informe de AI for the Planet Alliance, elaborado en colaboración con Boston Consulting Group (BCG) y BCG GAMMA. Si la IA puede ayudarnos con esta amenaza para la humanidad, ¿cómo no vamos a volcarnos con ella?

El consumo de energía de la IA

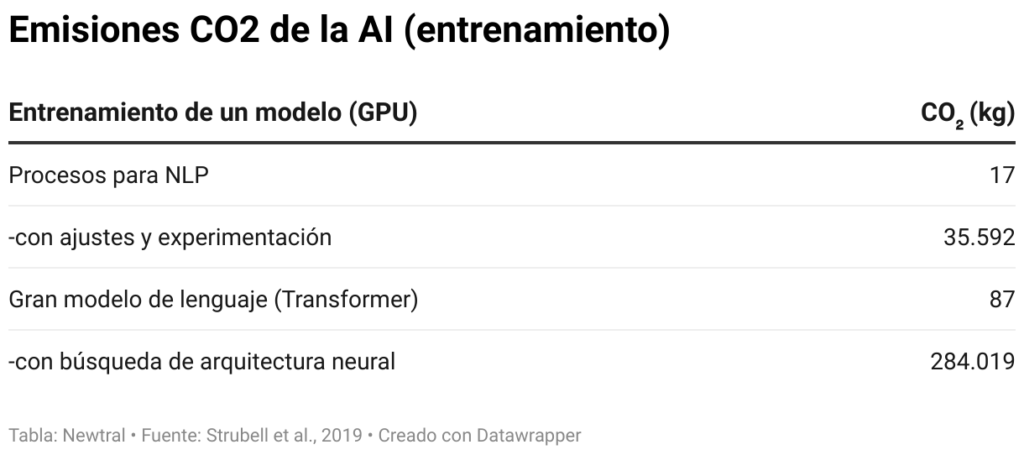

Para no depender de promesas de futuro, es interesante comprobar qué datos tenemos del impacto energético que ya están provocando estas empresas. La IA requiere poder computacional masivo para entrenar a sus modelos, y sabemos que puede consumir grandes cantidades de energía y generar emisiones de carbono.

La explosión del uso de Machine Learning (aprendizaje automático), y más concretamente los modelos basados en aprendizaje profundo están aumentando los consumos de energía y la huella de carbono de la industria en la nube. “El problema es que los grandes modelos de lenguaje que se están utilizando ahora necesitan enormes cantidades de datos, y no se puede entrenar en una única máquina (local) porque necesitarías una memoria brutal”, explica Amparo Alonso, investigadora en IA de la Universidad de La Coruña. Según la investigadora, no sólo es cosa de la nube, el problema del consumo energético del aprendizaje también tiene que ver con las grandes cantidades de datos que necesitan. “Utilizan datos muy complejos, textos muy grandes y también tienen que afinar muchos parámetros”, explica.

Las emisiones para el entrenamiento de GPT-3 fueron de 552 toneladas de CO2 y su consumo de energía fue de 1287 MWh, según un artículo científico escrito por autores de Google y de la Universidad de Berkeley. Esto es equivalente al consumo medio de un hogar estadounidense durante 120 años.

Google afirma que sus cargas de trabajo de aprendizaje automático representaron alrededor del 15% de su consumo total de energía en los últimos tres años. Un informe de la OCDE (Organización para la Cooperación y el Desarrollo Económico) recoge este dato y el de un gran proveedor de computación en la nube que calcula que entre el 7 y el 10% del gasto total de los clientes empresariales en infraestructura informática se destina a aplicaciones de IA, con un 3-4,5% utilizado para la formación de modelos de aprendizaje automático y un 4-4,5% dedicado al uso de estos modelos (lo que se conoce como inferencia).

Alonso no duda al afirmar que estamos usando más recursos por el uso de la IA, para poder ejecutar estos modelos y también para poder entrenarlos. “Y si esto sigue así el crecimiento en consumo energético va a aumentar de manera en que va a ser poco sostenible. Las previsiones nos dicen que las demandas de electricidad que requieren los centros de datos se pueden multiplicar por 15 al 2030 y eso significa que alcanzaríamos el 30% del consumo energético mundial para IA”, advierte.

¿Cuánta energía y de qué tipo consume la IA? La pregunta es difícil porque en primer lugar, la IA no es una sola cosa, ni un solo sistema, ni una sola actividad o empresa, ni siquiera una sola técnica. Toda su actividad es muy poco transparente, empezando por la infraestructura que la hace posible. Aunque se han hecho algunos estudios independientes, las grandes tecnológicas, las únicas con infraestructura como para desarrollar la IA generativa, no tienen obligación de dar estos datos, y no hay registros oficiales al ser empresas privadas. OpenAI no ha publicado ningún estudio sobre consumo de sus modelos.

En el grupo de investigación de Amparo Alonso, en la Universidad de A Coruña, sí incluyen el gasto energético del algoritmo, porque uno de sus objetivos es conseguir un mayor ahorro energético con la misma precisión de un algoritmo alternativo existente. De esto se trata el Plan de Algoritmos Verdes del Gobierno. “Se trata de que se publique el consumo de los algoritmos y se pueda avanzar”, explica Alonso.

Emisiones: otro indicador del impacto climático de la IA

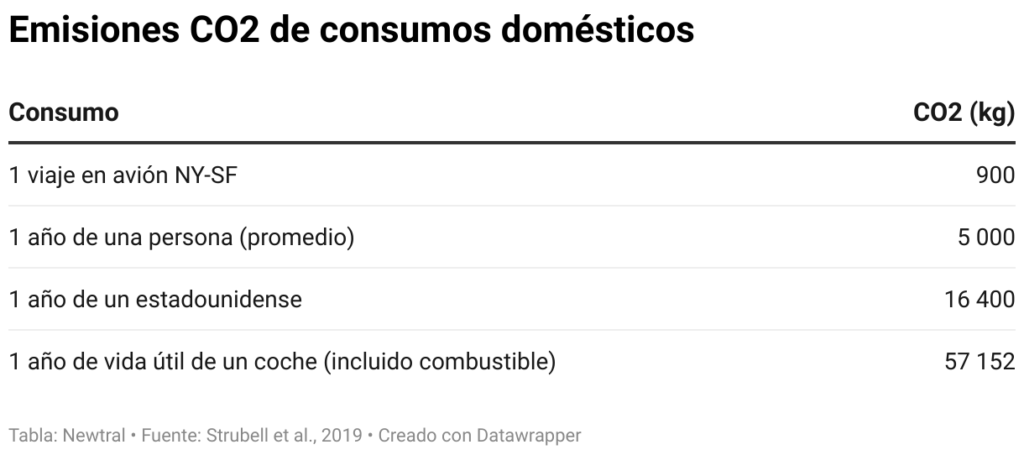

Además del gasto de energía, otro indicador que se utiliza para medir el impacto climático es la huella de carbono, es decir la cantidad de carbono que libera a la atmósfera una industria. La huella de carbono de la industria informática global alcanzó a la de la aviación hace un par de años, según una investigación de Lotfi Belkhir y Ahmed Elmeligi.

Entrenar un gran modelo de lenguaje natural, como ChatGPT, equivale a 125 vuelos de ida y vuelta de Nueva York a Pekín. O a la cantidad de carbono que producen cinco coches durante todo su ciclo de vida, incluyendo su producción, según uno de los primeros artículos científicos que hay sobre el tema, de Emma Strubell y su equipo de la Universidad de Massachusetts Amherst.

Otra investigación que llegó a resultados similares fue la de la Universidad de Copenhague, que calculó que entrenar GPT-3 de OpenAI es similar a conducir un coche hasta la Luna y volver. Lo hicieron a través de una herramienta de código abierto llamada Carbontracker, cuyo objetivo es predecir la huella de carbono de los algoritmos de IA. Se estima que en una sola sesión de entrenamiento se utiliza el equivalente al consumo energético de un año de 126 hogares daneses, y se emite la misma cantidad de CO2 que 700.000 kilómetros de conducción.

Estos investigadores y otros consultados por Newtral.es coinciden en afirmar que estas estimaciones tiran por lo bajo. “Una de las cosas que nos preocupa es que muchos de los datos que tenemos son de antes de la irrupción de tecnologías altamente demandantes, entre ellas la inteligencia artificial”, dice Aurora Gómez, portavoz de “Tu nube seca mi río”, un proyecto para visibilizar el impacto de los centros de datos en los recursos hídricos de España.

En su web, OpenAI ha publicado que desde 2012, la cantidad de computación utilizada para entrenar un solo modelo de lenguaje ha aumentado 10 veces por año.

Cuando la eficiencia energética tiene un límite

Los esfuerzos de la industria tecnológica en cuanto a eficiencia energética han sido medidos y han dado buenos resultados en el pasado. Pero a pesar de las ganancias en eficiencia del hardware, investigadores citados por la OCDE dicen que las demandas de computación de la IA han crecido más rápido que el rendimiento.

“La eficiencia tiene límites”, advierte Francisco del Pozo, especialista en cambio climático y energía de Greenpeace, que cita la paradoja de Jevons: cuanto más eficiente haces una cosa, más la usas. “Ellos intentan optimizar no sólo por temas climáticos sino por temas energéticos. Pero si la capacidad de cálculo aumenta diez veces con la conducción autónoma, el 5G, la IA… al final hacen falta más infraestructuras, más antenas, más servidores. Tendemos a pensar que estas tecnologías digitales son inocuas, pero realmente implican una cantidad de ordenadores y de consumos energéticos que siempre van a más y no son infinitos”.

Reducir esa huella de carbono usando energías renovables forma parte de unos compromisos a los que Amazon, Google y Microsoft, los tres mayores proveedores de nube, se han comprometido voluntariamente desde hace tiempo. Greenpeace denuncia que esos esfuerzos están siendo menoscabados por otra actividad de estas empresas: sus acuerdos comerciales con compañías petroleras y del gas, que están dando un nuevo impulso a la extracción de combustibles fósiles.

El informe “Oil in the cloud” documenta cómo innovaciones tecnológicas basadas en IA, desde la fracturación hidráulica hasta la perforación horizontal, han contribuido a impulsar el auge del esquisto en Estados Unidos y, como resultado, yacimientos de petróleo y gas que antes se consideraban demasiado arriesgados o caros están siendo explotados.

Lejos de ser la salvación contra el cambio climático, la IA es uno de los factores que incrementan el consumo energético de los centros de datos. La International Energy Agency dice que a pesar de las fuertes ganancias gracias a la eficiencia energética, el rápido crecimiento de las cargas de trabajo de los centros de datos ha llevado a un aumento sustancial del uso de energía en los últimos años, con un crecimiento de entre el 20 y el 40% anual.

En relación a la IA, creen probable que “la combinación del rápido crecimiento del tamaño de los modelos y de la demanda de computación supere las fuertes mejoras de la eficiencia energética, lo que se traducirá en un crecimiento neto del uso total de energía relacionada con la IA en los próximos años”. Aunque admiten que la IA por sí misma puede ayudar a reducir el uso de energía en los centros de datos, ven “probable que la adopción rápida y generalizada de chatbots de IA como ChatGPT de OpenAI y Google Bard acelere el crecimiento de la demanda de energía para la IA”.

Si se mantienen las tendencias del sector, investigadores de la Universidad de Copenhagen sostienen que “es probable que la IA y en particular el subcampo del aprendizaje profundo, se convierta en un importante responsable del cambio climático“.

No es IA lo que necesitamos contra el cambio climático

La argumentación de que necesitamos IA contra el cambio climático es “falaz” para Fernando Valladares, científico del CSIC, porque para abordar este problema realmente no nos hace mucha falta más conocimiento. El IPCC, el panel intergubernamental de expertos sobre el cambio climático, ya utiliza IA y ChatGPT, por ejemplo, para responder preguntas de usuarios y para informes. “Es útil, pero eso no es lo que nos hace falta ahora. Lo que nos hace falta ahora son seres humanos, al mando de la IA y al mando en general de las difíciles decisiones implicadas”, dice Valladares.

“La principal dificultad respecto a la resolución del problema del cambio climático es humana, no científica ni tecnológica. Es la sociedad, son los grupos de presión, son los acuerdos internacionales, es la dificultad para enfrentar la realidad… Un montón de problemas sociales, humanos, económicos, personales, psicológicos, antropológicos. Y eso no lo está abordando ni lo abordará la IA”, razona.

Fuentes

- Amparo Alonso Betanzos, investigadora en inteligencia artificial, coordinadora del grupo de investigación LIDIA (Laboratorio de I+D en Inteligencia Artificial), perteneciente al Centro de Investigación en TIC (CITIC) de la Universidad de La Coruña

- Francisco del Pozo, especialista en Cambio climático y Energía, Greenpeace

- Aurora Gómez, psicóloga especialista en comportamientos digitales y portavoz de Tu nube seca mi río

- Fernando Valladares, Científico del CSIC y profesor de Ecología de la Universidad Rey Juan Carlos

- AI and compute, OpenAI

- Informe: Oil in the Cloud, Greenpeace

- Data Centres and Data Transmission Networks, International Energy Agency

- Carbontracker: Tracking and Predicting the Carbon Footprint of Training Deep Learning Models, Lasse F. Wolff Anthony, Benjamin Kanding, Raghavendra Selvan

- Energy and Policy Considerations for Deep Learning in NLP, Emma Strubell, Ananya Ganesh, Andrew McCallum

- Assessing ICT global emissions footprint: Trends to 2040 & recommendations, Lotfi Belkhir, Ahmed Elmeligi

- Measuring the environmental impacts of artificial intelligence compute and applications, OECD

- Estimation of energy consumption in machine learning, Eva García-Martín, Crefeda Faviola Rodrigues, Graham Riley, Håkan Grahn

- 87% of Climate and AI Leaders Believe That AI Is Critical in the Fight Against Climate Change

- ET Conversations with ChatGPT founder: Sam Altman on fears from AI and more, The Economic Times (video)

- Microsoft invests in and partners with OpenAI to support us building beneficial AGI, OpenAI

- Carbon Emissions and Large Neural Network Training. David Patterson, Joseph Gonzalez, Quoc Le, Chen Liang, Lluis-Miquel Munguia, Daniel Rothchild, David So, Maud Texier, and Jeff Dean [PDF]

- Optimization could cut the carbon footprint of AI training by up to 75%

- Foto de Marek Piwnicki

- Foto de Tedder CC BY-SA 4.0: Data center de AWS en Oregon, EE.UU., via Wikimedia Commons